Deepfake, tra meme innocenti e pericoli mediatici

Deepfake: un prodotto che deve ancora pienamente maturare, ma che negli ulti anni ha già fatto parlare di sé e che oggi merita spazi di dibattito per (ri)conoscerlo e distinguerlo dai contenuti originali

Nelle ultime settimane, social e giornali hanno ripreso il ciclico focus sui deepfake. Protagonista in questo caso è un’impeccabile imitazione di Tom Cruise sul canale @deeptomcruise di TikTok. Un successo che continua a crescere con la pubblicazione di nuovi video e che l’ha portato quasi a triplicare i suoi follower nell’ultimo mese, arrivando al momento a contarne oltre 825 mila. Al contempo la zona commenti di ciascun video è stata invasa dalle reazioni degli utenti divisi tra un misto di stupore e di disagio: chi divenuto consapevole dell’inganno, una volta esaminato il profilo della pagina, chi ancora brancolante nel buio in cerca di chiarimenti. Si tratta di comportamenti comprensibili riguardanti manomissioni che siamo abituati a vedere nel cinema, ma il cui uso sta entrando anche nella nostra quotidianità grazie ai filtri dinamici di Instagram e Snapchat.

Oggi tuttavia, le possibilità di alterare un’immagine si stanno espandendo e allargando alla facile manipolazione anche dei video.

Non si è più di fronte a ritocchi di soggetti statici con programmi quali Photoshop. Nella nostra epoca cosa possiamo considerare reale nei mezzi digitali? Un tempo si poteva dibattere sulla faziosità della composizione dell’immagine in rapporto a un contesto diverso, andando a selezionare elementi adatti a un particolare storytelling, eppure ciò non pesava sulla veridicità degli stessi. Oggi non solo le immagini ma anche i video possono essere manipolati, inserendo oggetti inesistenti con la realtà aumentata, modificando le persone con programmi di deepfake, capaci di alterare persino la voce.

Deepfake di Tom Cruise su TikTok

Deepfake di Tom Cruise su TikTokCom’è possibile?

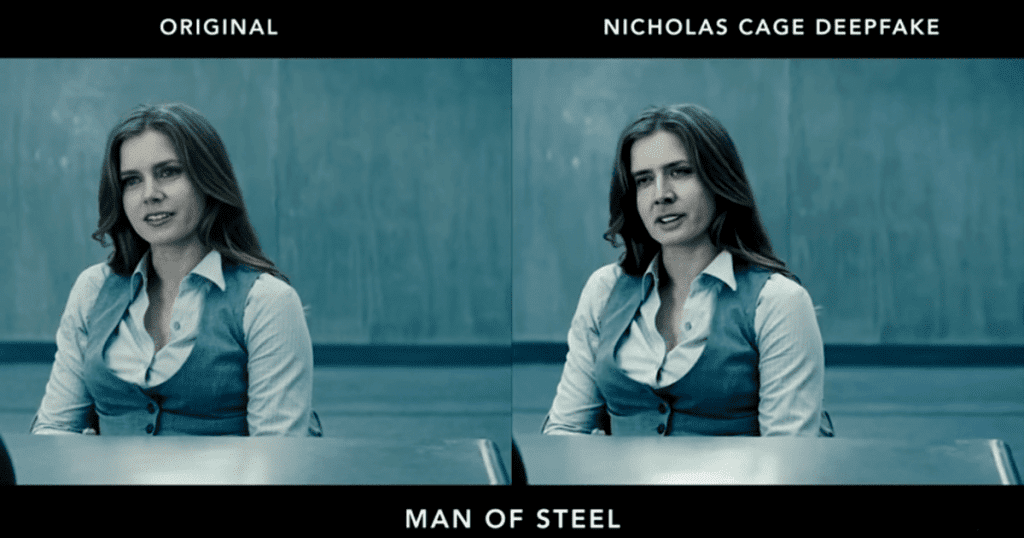

Della natura dei Deepfake ne parla la Treccani definendoli come “Filmati che presentano immagini corporee e facciali catturate in Internet, rielaborate e adattate a un contesto diverso da quello originario tramite un sofisticato algoritmo”. Eugenio Spagnuolo su Focus spiega che sono un nuovo tipo di video con face-swap (scambi di viso) realistici. Si tratta di elaborazioni basate su di un software che cerca un terreno comune tra due volti per incollare poi l’uno sull’altro, in modo dinamico.

Linus Sebastian, celebre youtuber con oltre 13 milioni di iscritti al canale Linus Tech Tips, spiega che i programmi che generano i deep fakes impiegano due intelligenze artificiali che lavorano congiunte in un meccanismo chiamato Generative Adversarial Network. La prima prende molti frame del soggetto che si vuole impersonificare e crea nuove immagini falsate. La seconda provvederà ad esaminare e valutare la verosimiglianza delle immagini create, scartando quelle venute male e comunicandolo alla prima. A questo punto si ritorna al primo punto e il processo va avanti finché la seconda non si riterrà soddisfatta della percentuale di immagini contraffatte che risulta convincente.

Ad oggi ci sono dunque molte app, quali Reface, che automatizzano questo processo, rendendo qualsiasi persona dotata di smartphone in grado di cambiare volto a vari personaggi. Nelle ultime settimane ha avuto particolare successo per la sua semplicità di utilizzo l’app Wombo. Essa consente di creare dei video di pochi secondi a partire da una foto, aggiungendo l’audio di una canzone scelta tra le 15 disponibili (per ora). La foto viene così animata, muovendo il volto a ritmo di musica.

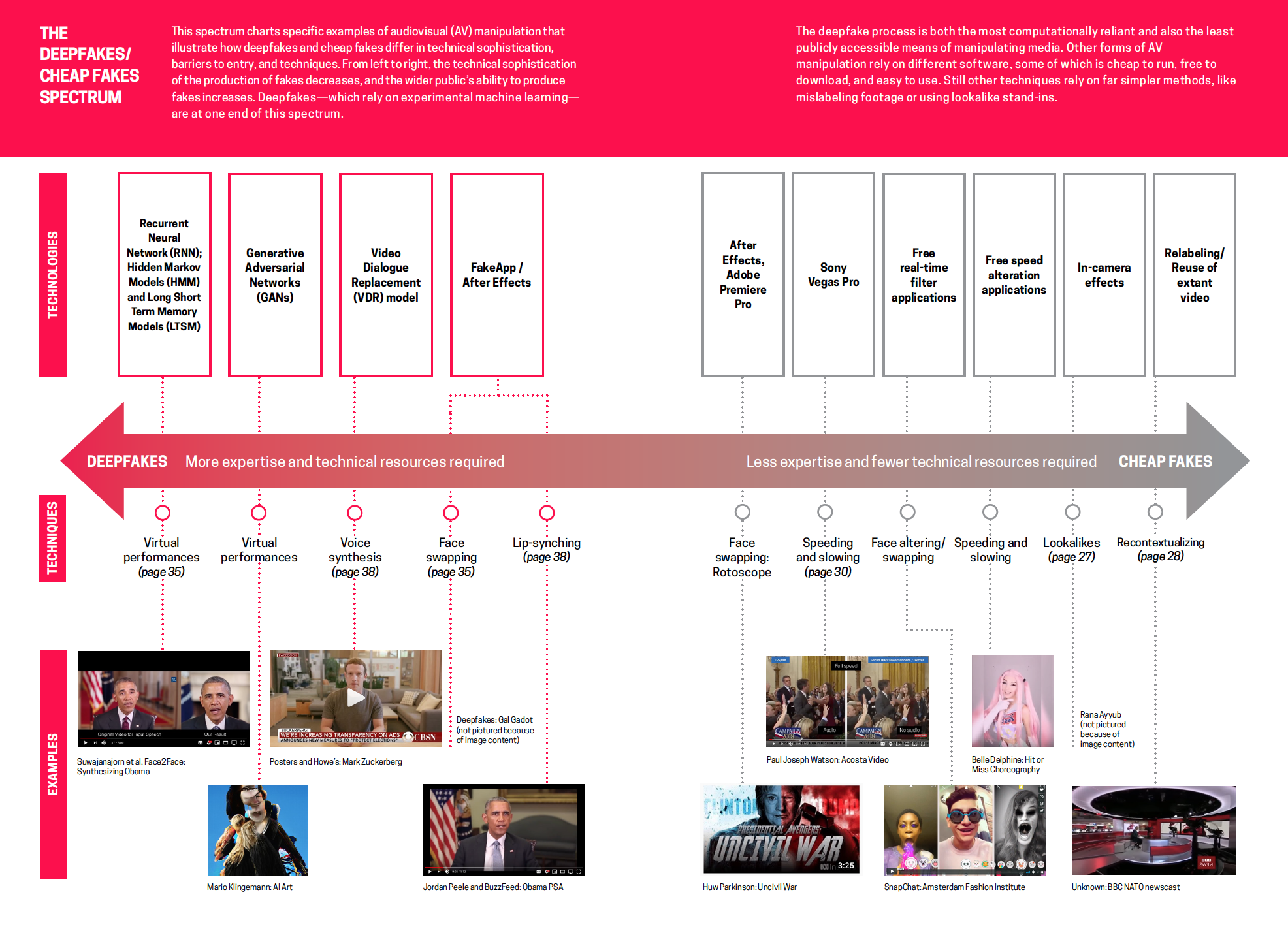

Come sostenuto da Britt Paris e Joan Donovan, ricercatrici della ONLUS Data and society, nel loro studio Deepfakes and cheap fakes, più che parlare di deepfake, ci si dovrebbe riferire a questi come casi di cheap fake ovvero “a manipolazioni audiovisive create con software più accessibili e meno costosi (o gratuiti)”. In esso vi è anche illustrato uno spettro che da sinistra a destra mostra una ventaglio dei casi appartenenti a questi due fenomeni ordinati in un crescendo di accessibilità tecnologica e d’inferiorità nel prezzo. In particolare si parte da tecnologie usate dai professionisti dell’industria di processori grafici, impegnati nel deep learning in ambiti che vanno dalla meteorologia alla sanità. Si passa poi a gruppi d’informatici interessati a sperimentare il deep learning per applicarlo a tecniche di grande qualità nella parziale falsificazione audio video. Anche i singoli programmatori vi rientrano con la creazione di programmi di deepfake quali FakeApp, FaceSwap e DeepFace Lab. Infine si giunge alle app gratuite coincidenti con i principali social (Instagram, SnapChat e TikTok).

Fonte: Deepfakes and cheap fakes, the manipulation of audio and visual evidence

Fonte: Deepfakes and cheap fakes, the manipulation of audio and visual evidenceEpisodi passati: il caso Raffaella Spone

I deepfake sono una tecnologia versatile e potente che negli anni è stata impiegata in vari modi. I primi episodi li videro impiegati come strumento di diffamazione di varie attrici di Hollywood con la realizzazione di video pornografici. Di portata minore, ma altrettanto esplicativa delle criticità di questo fenomeno, è il caso Spone dello scorso luglio. In Pennsylvania una madre è stata accusata di aver contraffatto un video per far cacciare dalla squadra di cheerleader tre ragazze per vendicare presunti torti subiti dalla figlia. Il video, molto convincente, ritraeva le ragazze mentre fumavano e bevevano ed era poi stato inviato Spone, ai responsabili della palestra, ottenendo l’espulsione di una di loro, poi alle stesse vittime con tanto di messaggi intimidatori. Finché la denuncia delle famiglie ha condotto le forze dell’ordine all’artefice.

Raffaela Spone

Raffaela SponeAttualmente i deepfake si muovono in un territorio non ancora regolamentato, in un limbo sospeso tra la libertà d’espressione e la diffamazione costituita dall’atto della loro pubblicazione sul web nei confronti delle persone coinvolte. Eppure le avvisaglie di questa nuova moda dell’inganno si erano già manifestate. Se questi posso essere usati, sia con finalità goliardiche sia con intenti meno innocenti, i pericoli aumentano esponenzialmente quando a partire da essi si vogliono creare degli inciampi comunicativi a livello politico.

Nell’aprile 2018 BuzzFeed creò un video che mostrava Barack Obama scagliarsi contro le fake news e contro il presidente Trump. In realtà si trattava di un esperimento del comico Jordan Peele. Mentre nel 2019 il Massachusetts Institute of Technology’s Centre for Advanced Virtuality pubblicò un documentario di 7 minuti intitolato “In Event of Moon Disaster” nel quale il presidente Nixon dichiarava che Neil Armstrong e Buzz Aldrin erano rimasti intrappolati durante l’allunaggio del 1969. Francesca Panetta, una delle direttrici di MIT Virtuality in un’intervista a space.com dichiarò: “This alternative history shows how new technologies can obfuscate the truth around us, encouraging our audience to think carefully about the media they encounter daily”.

Come si sta reagendo?

Purtroppo a oggi non vi sono risposte definitive e condivise. Il problema confluisce sul macroargomento denominato fake news ma al contempo aggiunge uno strato ulteriore di criticità dettato dalla natura dei video, ancora percepita come incorruttibile degli strumenti digitali.

Secondo Altalex, quotidiano d’informazione giuridica, nel nostro Paese non ci sono leggi che tutelano dal fenomeno dei deepfake (e in modo particolare dal deepnude). “Basti pensare al reato di cui all’art. 612 ter del Codice penale, comunemente conosciuto come Revenge porn, termine volto a indicare la divulgazione a scopo di ricatto, denigrazione o vendetta, da parte dell’ex partner, di foto e video a contenuto sessuale o addirittura pornografico, che, nel caso del deepnude, sono ovviamente falsi. La questione assume altresì rilievo se si considera che questa forma di tutela non sembra potersi applicare anche alle immagini create artificialmente, nonostante l’offesa al bene giuridico tutelato risulti potenzialmente la stessa”.

Tuttavia lo scorso anno il Garante della Privacy si è mobilitato in due situazioni.

La prima a ottobre nei confronti di Telegram. Nello specifico si è scoperta l’esistenza di un bot creato da un utente che ha coinvolto decine di migliaia di donne per lo più non riguardanti persone famose. Tutto è partito da DeepNude, un app sviluppata per divertimento la cui veloce rimozione dal web non ha fatto altro che produrne dei cloni tra cui quello citato. L’automazione consiste nel caricare la foto della vittima alla quale verranno rimossi i vestiti.

La seconda è stata a fine anno con la pubblicazione di un vademecum per la protezione dei dati personali la cui diffusione sarà necessaria per favorire una maggiore cultura ed sensibilità civica verso questo fenomeno. In esso si spiega la natura di questi falsi digitali con particolare riguardo ai deepnude, ricollegandolo al reato del revenge porn, del cyberbullismi, della pornografia illegale e della pedofilia. L’ultimo scenario descritto dal Garante riguarda cybercrime quali lo spoofing (furto d’informazioni attraverso falsificazione dell’identità digitale), il phishing (che opera fingendosi un ente affidabile come la propria banca) e il ransomware (un programma informatico usato per bloccare determinati file di un utente e richiedente una somma in denaro per ripristinarli).

Benché i deepfake siano ancora un fenomeno marginale e poco trattato dai media, essi sono qui per rimanere andando ad aggiungere un altro pezzo all’intricato puzzle delle fake news. La profonda sfiducia in ciò che possiamo ritenere vero non dovrebbe abbatterci ma essere un incentivo a una maggiore responsabilità del nostro agire quotidiano. Forse è proprio la gioventù cresciuta con i social che svilupperà più velocemente gli anticorpi della messa in discussione di ciò che ci viene presentato, a differenza del pubblico più anziano legato alle abitudini di un’informazione più istituzionalizzata e autorevole.

di Francesco Scomazzon

Scrivi un commento